分类 语言大模型 下的文章

大模型和知识图谱融合

大模型预训练参数、数据、训练时间

nohup python pre_brand.py>>./train.log 2>&1 &

一、Bloom

1.参考论文

https://arxiv.org/pdf/2211.05100.pdf

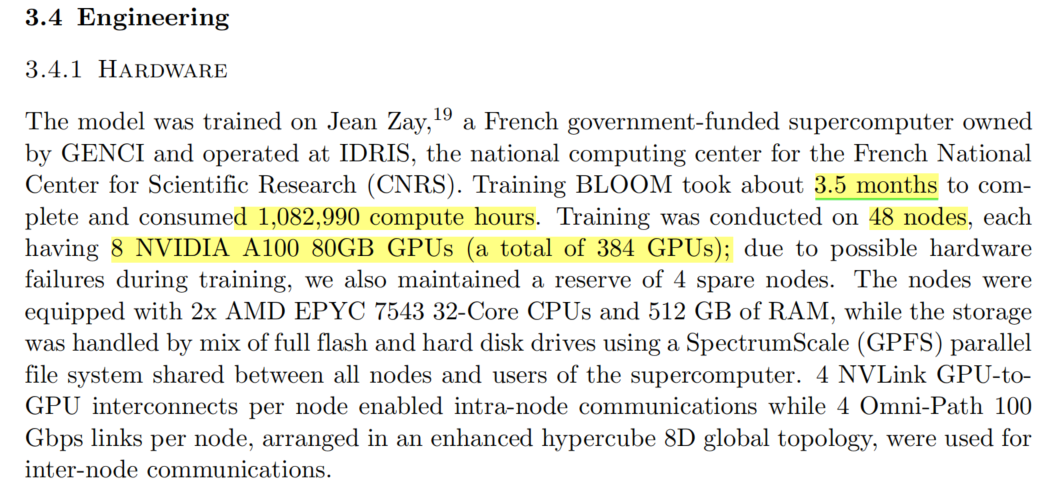

2.硬件组成

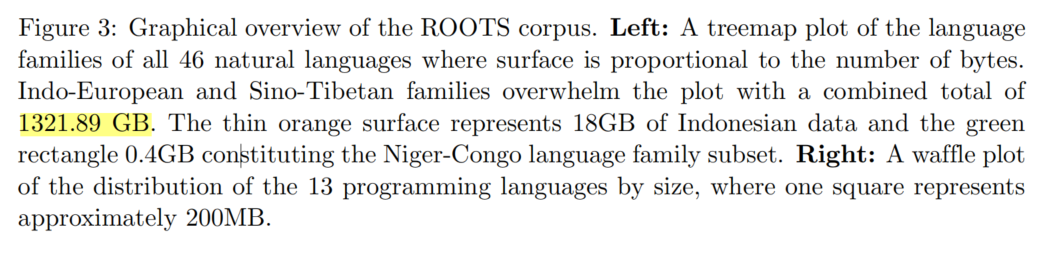

3.数据量

epoch:

token:3500亿token

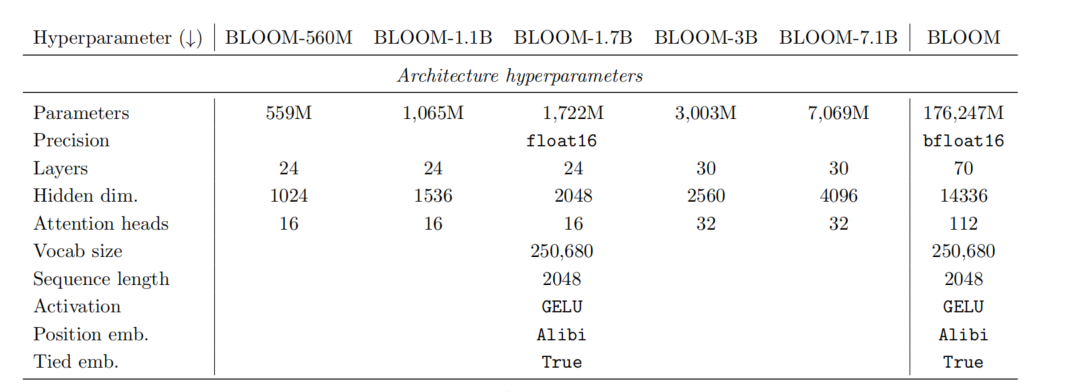

4.网络参数

模型参数量:176B

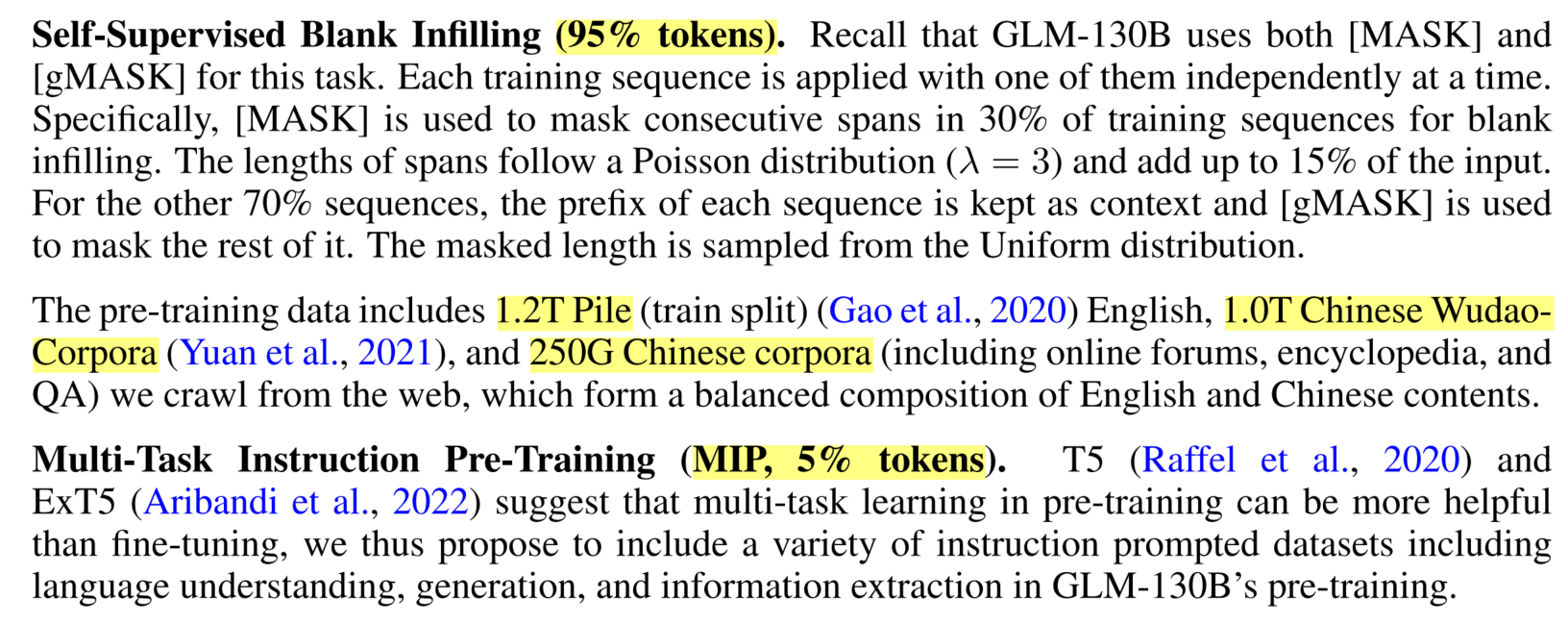

二、GLM

1.参考论文

https://openreview.net/pdf?id=-Aw0rrrPUF

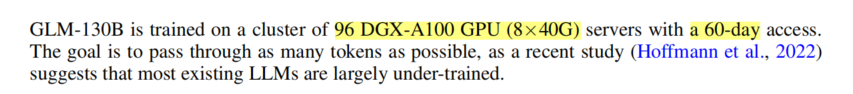

2.硬件组成

3.数据量

epoch:1

token:4000亿token

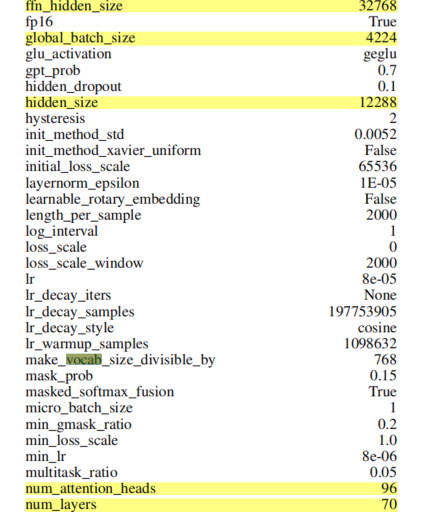

4.网络参数

模型参数量:130B

三、GPT-3

1.参考论文

https://arxiv.org/pdf/2005.14165.pdf

2.硬件组成

论文中没有说明:

。英伟达表示,GPT-3 需要 512 颗 V100 显卡

训练 7 个月,或者 1024 颗 A100 芯片训练一个月

3.数据量

epoch:1

token:4000亿token

4.网络参数

模型参数量:175B

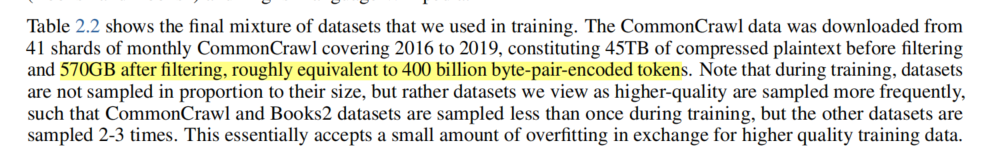

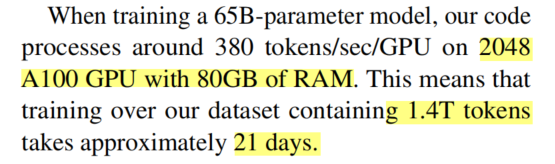

四、LLaMa

1.参考论文

https://arxiv.org/pdf/2302.13971.pdf

2.硬件组成

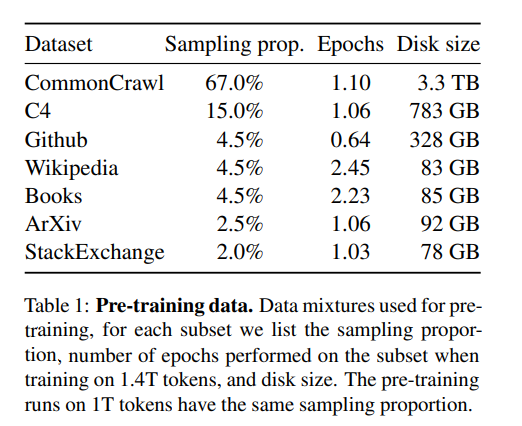

3.数据量

epoch:1

token:1.4万亿

disk size:4.9TB

4.网络参数

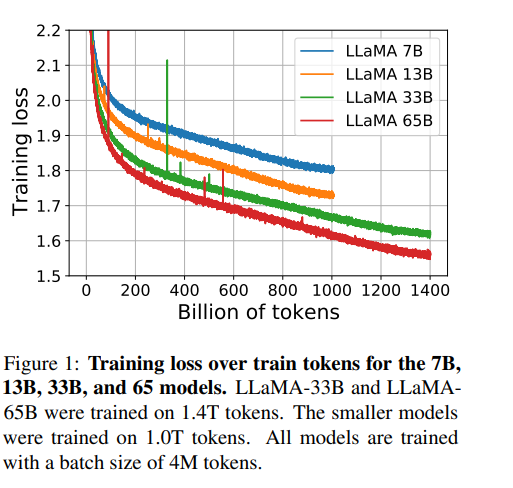

模型参数量:

参数大小:65B

| 模型 | 参数量 | 训练数据disk size | 训练数据tokens | 训练时间 | GPU数量 | epoch | 2B参数,500G语料预估训练天数 |

|---|---|---|---|---|---|---|---|

| Bloom | 176B | 1.6TB | 3500亿 | 205天 | 384 A100 80G=30TB显存 | 1 | 35天 |

| GLM | 130B | 2.4TB | 4000亿 | 60天 | 768 A100 40G=30TB显存 | 1 | 12天 |

| GPT3 | 175B | 570GB | 4000亿 | 30天 | 1024 A100 80G=80TB显存 | 1 | 12天 |

| LLaMa | 65B | 4.9T | 14000亿 | 21天 | 2048 A100 80G=160TB显存 | 1 | 13天 |

| 我们 | 2B | 0.5T | 1100亿 | ?天 | 8 A100 80G=0.625TB显存 | 1 | 12-35天 |

此内容被密码保护

Megatron-DeepSpeed

nvidia apex是什么

APEX是什么 APEX是英伟达开源的,完美支持PyTorch框架,用于改变数据格式来减小模型显存占用的工具。 其中最有价值的是amp(Automatic Mixed Precision),将模型的大部分操作都用Float16数据类型测试,一些特别操作仍然使用Float32。