Megatron-DeepSpeed

nvidia apex是什么

APEX是什么 APEX是英伟达开源的,完美支持PyTorch框架,用于改变数据格式来减小模型显存占用的工具。 其中最有价值的是amp(Automatic Mixed Precision),将模型的大部分操作都用Float16数据类型测试,一些特别操作仍然使用Float32。

APEX是什么 APEX是英伟达开源的,完美支持PyTorch框架,用于改变数据格式来减小模型显存占用的工具。 其中最有价值的是amp(Automatic Mixed Precision),将模型的大部分操作都用Float16数据类型测试,一些特别操作仍然使用Float32。

| 公司 | AI大模型 | 模型参数 | 训练数据 | 发布时间 | 应用场景 | AIGC应用场景 |

|---|---|---|---|---|---|---|

| 百度 | 文心·NLP大模型 文心·CV大模型 跨模态大模 | - | - | 发布时间 | 智能搜索 智能云 自动驾驶 智能地图 汽车智能化 解决方案 智能家居 | AI作画 AI写作 AI编剧 AI语音 AI视频创作 数字人 |

| 阿里 | M6 | 10万亿 | - | 发布时间 | 阿里云 钉钉 | AI海报设计 |

| openAI | GPT-1 GPT-2 GPT-3 ChatGPT | 1.17亿 15亿 1750亿 1750亿 | 5G 40G 45T | 2018年6月 2019-2 2020-5 2022-11 | 对话 | 对话 |

| 元语智能 | ChatYuan | 百亿 | - | 2022-11 | - | 对话 |

| 华为 | 盘古 | - | - | - | - | 对话 |

| 华为+中科院自动化所 | 紫极太初 | 千亿 | - | - | - | 对话 |

| 北京智源人工智能研究院 | 悟道 | 1.75万亿 | 悟道1.0 悟道2.0 | - | - | 对话 |

https://github.com/clue-ai/ChatYuan

hatYuan: 元语功能型对话大模型

这个模型可以用于问答、结合上下文做对话、做各种生成任务,包括创意性写作,也能回答一些像法律、新冠等领域问题。它基于PromptCLUE-large结合数亿条功能对话多轮对话数据进一步训练得到。

PromptCLUE-large:在1000亿token中文语料上预训练,累计学习1.5万亿中文token,并且在数百种任务上进行Prompt任务式训练。针对理解类任务,如分类、情感分析、抽取等,可以自定义标签体系;针对多种生成任务,可以进行采样自由生成。

https://github.com/google-research/text-to-text-transfer-transformer

https://github.com/CLUEbenchmark/pCLUE

pCLUE: Large-scale Prompt-based Dataset for Multi-task and Zero-shot Learning in Chinese

pCLUE:基于提示的大规模预训练数据集,用于多任务学习和零样本学习

数据量: 120万训练数据,73个Prompt

1.单分类tnews

2.单分类iflytek

3.自然语言推理ocnli

4.语义匹配afqmc

5.指代消解-cluewsc2020

6.关键词识别-csl

7.阅读理解-自由式c3

8.阅读理解-抽取式cmrc2018

9.阅读理解-成语填空chid

https://github.com/PaddlePaddle/ERNIE

文心大模型ERNIE是百度发布的产业级知识增强大模型,涵盖了NLP大模型和跨模态大模型。2019年3月,开源了国内首个开源预训练模型文心ERNIE 1.0,此后在语言与跨模态的理解和生成等领域取得一系列技术突破,并对外开源与开放了系列模型。

ERNIE 1.0

ERNIE 2.0

ERNIE 3.0

文心一言,暂未发布,3月份发布

GPT-1:

GPT-2:https://github.com/openai/gpt-2

GPT-3:https://github.com/openai/gpt-3

ChatGPT: https://chat.openai.com/

GPT-1、GPT-2:模型均是开源的,GPT-3模型没有开源

GPT-1:https://cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf

GPT-2:https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf

GPT-3:https://arxiv.org/pdf/2005.14165.pdf

instructGPT:https://arxiv.org/pdf/2203.02155.pdf

作者:机器之心

链接:https://zhuanlan.zhihu.com/p/597100830

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

在机器学习中,模型的能力是指模型执行特定任务或一组任务的能力。模型的能力通常通过它能够优化其目标函数的程度来评估。例如,用来预测股票市场价格的模型可能有一个衡量模型预测准确性的目标函数。如果该模型能够准确预测股票价格随时间的变化,则认为该模型具有很高的执行能力。一致性关注的是实际希望模型做什么,而不是它被训练做什么。它提出的问题是「目标函数是否符合预期」,根据的是模型目标和行为在多大程度上符合人类的期望。假设要训练一个鸟类分类器,将鸟分类为「麻雀」或「知更鸟」,使用对数损失作为训练目标,而最终目标是很高的分类精度。该模型可能具有较低的对数损失,即该模型的能力较强,但在测试集上的精度较差,这就是一个不一致的例子,模型能够优化训练目标,但与最终目标不一致。原始的 GPT-3 就是非一致模型。类似 GPT-3 的大型语言模型都是基于来自互联网的大量文本数据进行训练,能够生成类似人类的文本,但它们可能并不总是产生符合人类期望的输出。事实上,它们的目标函数是词序列上的概率分布,用来预测序列中的下一个单词是什么。但在实际应用中,这些模型的目的是执行某种形式的有价值的认知工作,并且这些模型的训练方式与期望使用它们的方式之间存在明显的差异。尽管从数学上讲,机器计算词序列的统计分布可能是建模语言的高效选择,但人类其实是通过选择最适合给定情境的文本序列来生成语言,并使用已知的背景知识和常识来辅助这一过程。当语言模型用于需要高度信任或可靠性的应用程序(如对话系统或智能个人助理)时,这可能是一个问题。

BM25算法本质上来说是tf-idf的升级版本。

tf-idf的全程是:词频-逆文档频率(term frequency–inverse document frequency),就是词频*逆文档频率。

BM25全程:best match,思想和tf-idf是一样的。

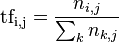

在一份给定的文件里,词频(term frequency,TF)指的是某一个给定的词语在该文件中出现的频率。这个数字是对词数(term count)的归一化,以防止它偏向长的文件。(同一个词语在长文件里可能会比短文件有更高的词数,而不管该词语重要与否。)对于在某一特定文件里的词语 t_{i} 来说,它的重要性可表示为:

以上式子中 n_{i,j} 是该词在文件d_{j}中的出现次数,而分母则是在文件d_{j}中所有字词的出现次数之和。

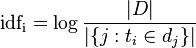

其中

|D|:语料库中的文件总数

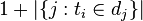

$|\{ j: t_{i} \in d_{j}\}| $:包含词语 t_{i} 的文件数目(即 n_{i,j} neq 0的文件数目)如果该词语不在语料库中,就会导致被除数为零,因此一般情况下使用

$ Score(Q, d) = \sum_{i = 1}^t w_i * R(q_i, d) $

上面式子中wi表示qi的权重,R(qi,d)为qi和d的相关性,Score(Q,d)就是每个语素qi和d的相关性的加权和。

wi 的计算方法有很多,一般是用IDF来表示的,但这里的IDF计算和上面的有所不同,具体的表达式如下:

$w_i = IDF(q_i) = \log \frac {N - n(q_i) + 0.5} {n(q_i) + 0.5}$

上面式子中N表示文本集合中文本的总数量,n(qi)表示包含qi这个词的文本的数量,0.5主要是做平滑处理。

R(qi,d)的计算公式如下:

$R(q_i, d) = \frac {f_i * (k_1 + 1)} {f_i + K} * \frac {qf_i * (k_2 + 1)} {qf_i + k_2}$

其中

$K = k_1 * (1 - b + b * \frac {dl} {avg dl})$

上面式子中fi为qi在文本d中出现的频率,qfi为qi在Q中出现的频率,k1,k2,b都是可调节的参数,dl,avgdl分别为文本d的长度和文本集D中所有文本的平均长度

一般qfi=1,取k2=0,则可以去除后一项,将上面式子改写成:

$R(q_i, d) = \frac {f_i * (k_1 + 1)} {f_i + K}$

通常设置k1=2,b=0.75。参数b的作用主要是调节文本长度对相关性的影响。

一般取值范围是

k1∈[1.2,2.0]:它用于调节饱和度变化的速率。数值越低则饱和的过程越快速。

b=0.75:字段长度归约用 b 来表示,它的值在 0 和 1 之间,1 意味着全部归约化,0 则不进行归约化。

文献:

1.https://zhuanlan.zhihu.com/p/113224707

2.https://www.cnblogs.com/jiangxinyang/p/10516302.html

3.https://d.shikey.com/jike/%E6%9E%81%E5%AE%A2%E6%97%B6%E9%97%B4%E5%B7%B2%E5%AE%8C%E7%BB%93/55%20AI%E6%8A%80%E6%9C%AF%E5%86%85%E5%8F%82%E5%AE%8C%E7%BB%93/pdf/019%E8%AE%B2%E7%BB%8F%E5%85%B8%E6%90%9C%E7%B4%A2%E6%A0%B8%E5%BF%83%E7%AE%97%E6%B3%95%EF%BC%9ABM25%E5%8F%8A%E5%85%B6%E5%8F%98%E7%A7%8D%EF%BC%88%E5%86%85%E9%99%84%E5%85%A8%E5%B9%B4%E7%9B%AE%E5%BD%95%EF%BC%89.pdf?preview