HMM,CRF区别

对于CRF,直接用最大熵准则建模p(Y|X)的概率。

而HMM,是在做了markov假设下去建模p(Y,X)(即一切观察量的联合概率分布)

对于CRF,直接用最大熵准则建模p(Y|X)的概率。

而HMM,是在做了markov假设下去建模p(Y,X)(即一切观察量的联合概率分布)

多模型评估的指标可以分为以下几个类别

要计算这几个指标先要了解几个概念:

FN:False Negative,被判定为负样本,但事实上是正样本。

FP:False Positive,被判定为正样本,但事实上是负样本。

TN:True Negative,被判定为负样本,事实上也是负样本。

TP:True Positive,被判定为正样本,事实上也是证样本。

1.Accuracy (准确率)

$ac=\frac {TP+TN}{TP+TN+FP+FN}$

2.Precision(精确率、查准率)

$P = \frac {TP}{TP+FP}$

解释:正样本占分类器所分的正样本的比例

3.Recall(召回率,查全率)

$R = \frac {TP}{TP + FN}$

解释:正样本占真正的正样本的比例

我们平常所说的准确率,召回率通常指正样本的,因为我们模板大多比较关心正样本。

$P = \frac {TP}{TP+FP}$

$R = \frac {TP}{TP + FN}$

$P = \frac {TN}{TN+FN}$

$R = \frac {TN}{TN + FP}$

这里就要考虑宏平均和微平均

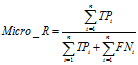

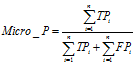

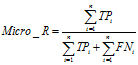

是先对每一个类统计指标值,然后在对所有类求算术平均值。

是对数据集中的每一个实例不分类别进行统计建立全局混淆矩阵,然后计算相应指标。

F1值是精确率和召回率的调和均值,即F1=2PR/(P+R),相当于精确率和召回率的综合评价指标。

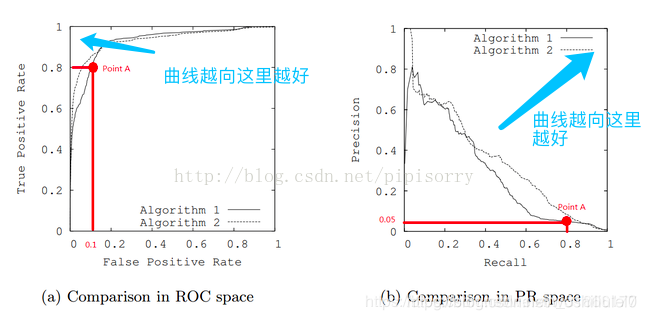

ROC全称是“受试者工作特征”(Receiver OperatingCharacteristic)曲线。我们根据学习器的预测结果,把阈值从0变到最大,即刚开始是把每个样本作为正例进行预测,随着阈值的增大,学习器预测正样例数越来越少,直到最后没有一个样本是正样例。在这一过程中,每次计算出两个重要量的值,分别以它们为横、纵坐标作图,就得到了“ROC曲线”。

###### 2.横纵坐标轴

纵坐标:真阳率:$TPR = \frac {TP}{TP + FN}$

横坐标:假阳率(误判率):$FPR = \frac {TP}{TN + FP}$

1.如果正负样本比例差不多,roc曲线和pr曲线基本一致。

2.如果样本比例失调,roc曲线比pr曲线更能判定模型好坏。

3.举个极端的例子:

100个去医院看病,其中99个艾滋病,一个正常人,结果医生将100个人都看成艾滋病人。则:

TP=99

FP=1

TN=0

FN=0

则:P=99%,R =100%,则PR曲线的效果就很好,实际分类效果不好

而:ROC曲线:TPR=100% ,FPR=100%,可看出ROC曲线效果不好,与实际一直。可以看出ROC曲线更好

那么这个指标代表什么呢?这个指标想表达的含义,简单来说其实就是随机抽出一对样本(一个正样本,一个负样本),然后用训练得到的分类器来对这两个样本进行预测,预测得到正样本的概率大于负样本概率的概率。

在有M个正样本,N个负样本的数据集里。一共有MN对样本(一对样本即,一个正样本与一个负样本)。统计这MN对样本里,正样本的预测概率大于负样本的预测概率的个数。

,其中,

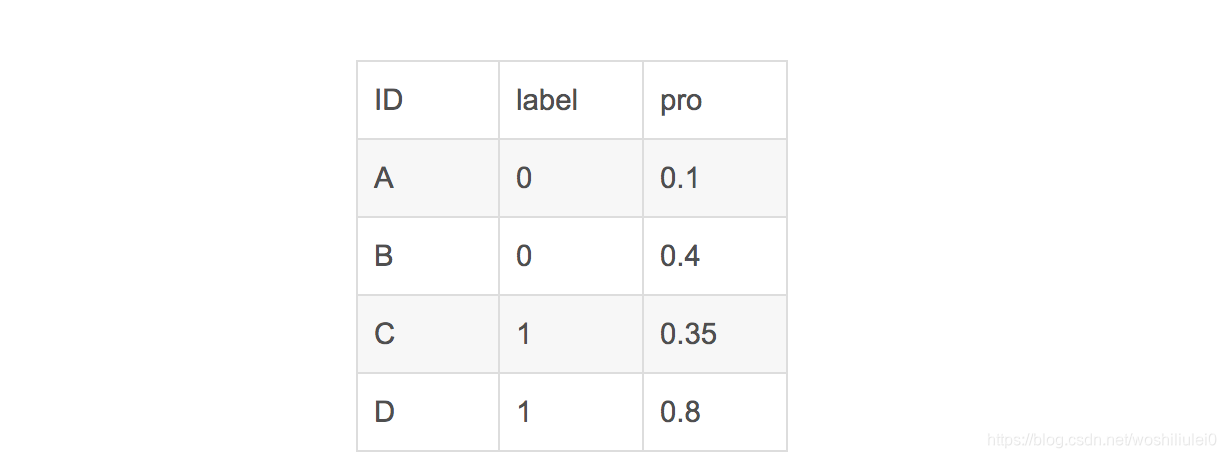

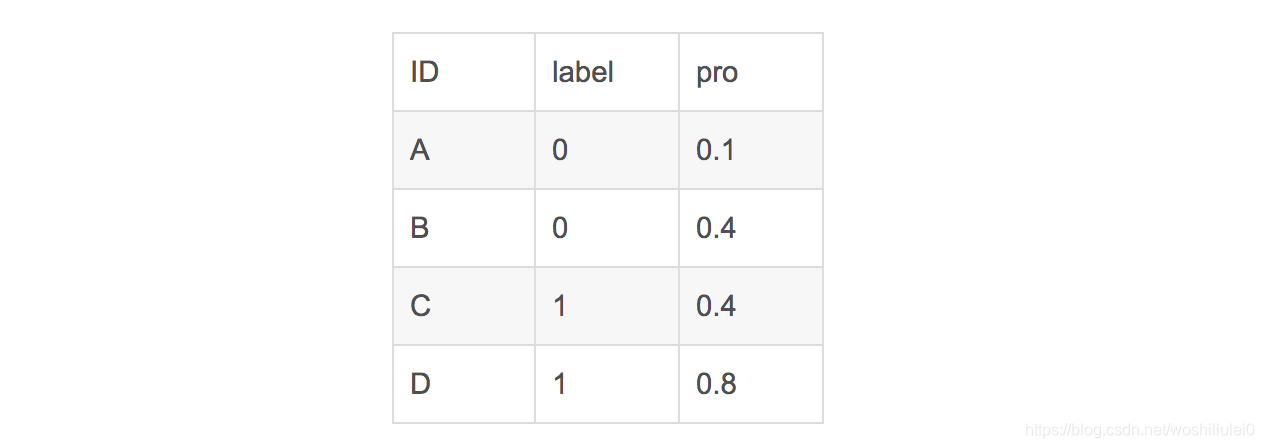

这样说可能有点抽象,我举一个例子便能够明白。

假设有4条样本。2个正样本,2个负样本,那么M*N=4。即总共有4个样本对。分别是:

(D,B),(D,A),(C,B),(C,A)。

在(D,B)样本对中,正样本D预测的概率大于负样本B预测的概率(也就是D的得分比B高),记为1

同理,对于(C,B)。正样本C预测的概率小于负样本C预测的概率,记为0.

最后可以算得,总共有3个符合正样本得分高于负样本得分,故最后的AUC为

在这个案例里,没有出现得分一致的情况,假如出现得分一致的时候,例如:

同样本是4个样本对,对于样本对(C,B)其I值为0.5。

最后的AUC为

1.同义词替换(Synonym Replacement, SR):从句子中随机选取n个不属于停用词集的单词,并随机选择其同义词替换它们;

2.随机插入(Random Insertion, RI):随机的找出句中某个不属于停用词集的词,并求出其随机的同义词,将该同义词插入句子的一个随机位置。重复n次;

3.随机交换(Random Swap, RS):随机的选择句中两个单词并交换它们的位置。重复n次;

4.随机删除(Random Deletion, RD):以 $p$ 的概率,随机的移除句中的每个单词。

第一种方式主要是利用同义替换的思想。 文中介绍了几个相关的方法,主要还是在于字、词、和句子结构层面上做数据增强。

除了传统的字典、词向量相似度替换的方法,我觉得用mlm的方式去做数据增强这个点更加新颖和符合intuition。

样本生成

模型预测

5、第二种就是通过“回译”的方法,这在阅读理解领域的榜单中一度有人使用过,比如说《attention is all you need》中在squad数据集上就使用了这个trick。

6、句法级别的改写,生成句法树然后利用规则替换

7.通过上述两个图,能很容易理解,就是预测mask位置的token,本身模型输出的是概率值,所以可以进行一个有效排序,而生成top k个近似的结果。

8、第三种方式, Text Surface Transformation,主要是对句子进行一定规则的扩张和缩写,比如it is可以改写为it's

9、随机噪声插入,这在addsent数据集的论文中使用过,可以使用随机插入、拼写错误插入、句子级别的打乱

10、可以认为是一种句子之间相互增强,本质来将就是找到一个和原始句子相似的句子来替代,类似句子改写?但这句子是真实的?

$L_\theta(x) =- \frac{1}{m}\sum_{i=1}^{m}(y_{i}log \hat{y_{i}}+(1-y_{i})log(1- \hat{y_{i}}))$

问题:在0,1分类问题中为什么不用平方损失

从梯度优化方向来回答:

数据视图

直方图

散点图