Ernie-1.0算法

一、 ERNIE-B的掩码机制

ERNIE-B的掩码机制如图1所示,它由BERT的随机掩码再加前面我们介绍的短语级别掩码和实体级别掩码。

图1:ERNIE-B的三种掩码

基本级别掩码(Basic-Level Masking):

这里采用了和BERT完全相同的掩码机制,在进行中文语料时,这里使用的是字符级别的掩码。在这个阶段并没有加入更高级别的语义知识。

短语级别掩码(Phrase-Level Masking):

在这个阶段,首先使用语法分析工具得到一个句子中的短语,例如图1中的“a serious of”,然后随机掩码掉一部分,并使用剩下的对这些短语进行预测。在这个阶段,词嵌入中加入了短语信息。

实体级别掩码(Entity-Level Masking):

在这个阶段,将句子中的某些实体掩码掉,这样模型就有了学习更高级别的语义信息的能力。

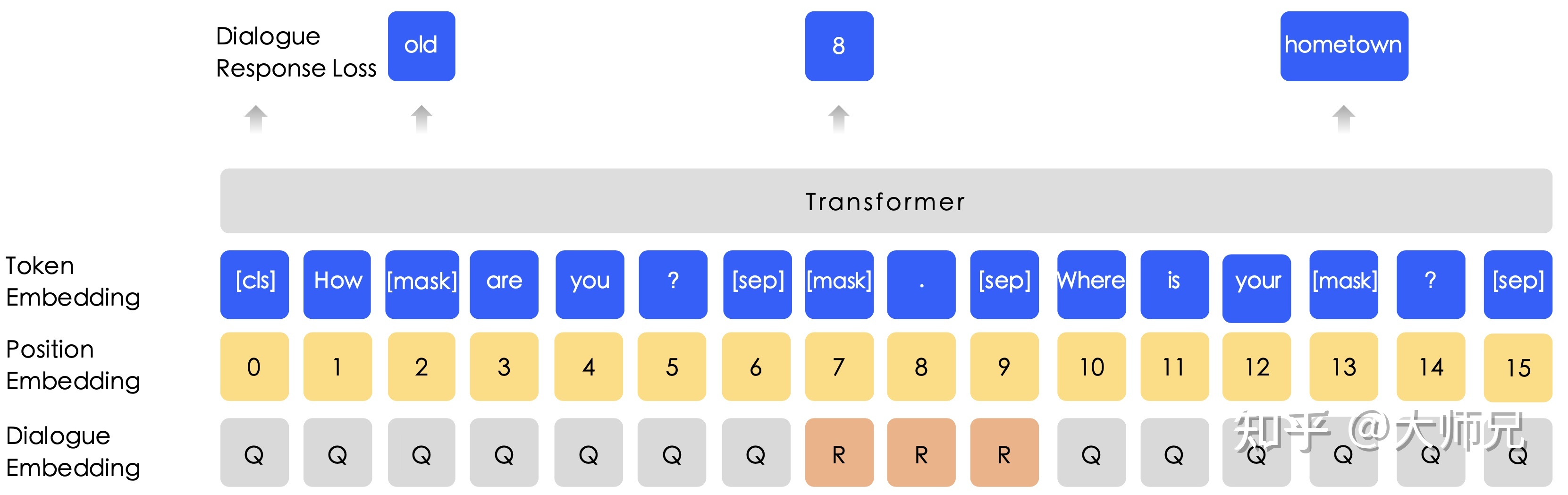

二、 DLM

得益于百度贴吧强大的数据量,ERNIE-B使用了海量的对话内容,因此在ERNIE-B中使用了对话语言模型(Dialogue Language Model,DLM)。作者认为一组对话可能有多种形式,例如QRQ,QRR,QQR等(Q:Query,R:Response)。为了处理这种多样性,ERNIE-B给输入嵌入中加入了对话嵌入(Dialogue Embedding)特征。另外在ERNIE-B中,DLM是可以和掩码语言模型的兼容的,如图2所示。