大模型分布式训练并行技术|deepspeed

一、简介

Deepspeed是微软推出的一个开源分布式工具,其集合了分布式训练、推断、压缩等高效模块。

该工具旨在提高大规模模型训练的效率和可扩展性。

它通过多种技术手段来加速训练,包括模型并行化、梯度累积、动态精度缩放、本地模式混合精度等。

DeepSpeed还提供了一些辅助工具,如分布式训练管理、内存优化和模型压缩等,以帮助开发者更好地管理和优化大规模深度学习训练任务。

二 、分布式训练方法

如今的大模型训练,离不开各种分布式的训练框架,一般来说,并行策略包含:数据并行、模型并行、流水线并行。

三种方式:数据并行、模型并行、3D并行

参考:https://juejin.cn/post/7254001262646738981

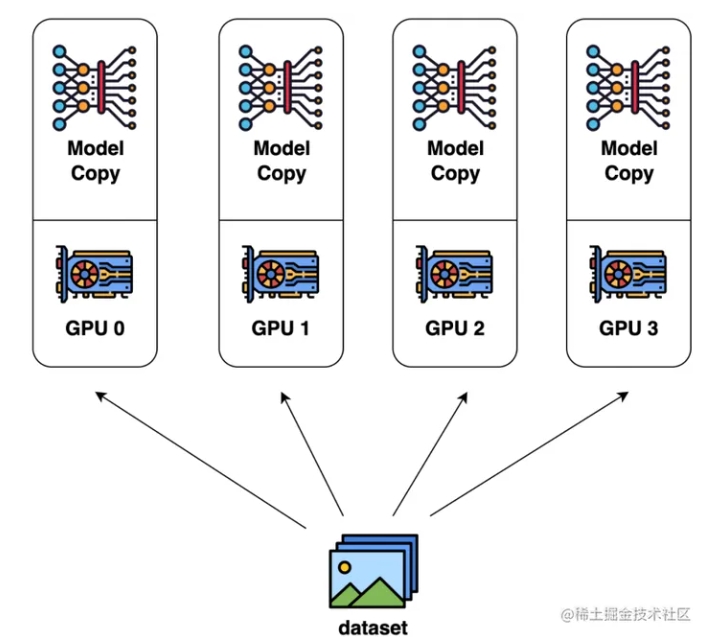

1、数据并行DP (Data Parallel)

数据并行是最常见的并行形式,因为它很简单。在数据并行训练中,数据集被分割成几个碎片,每个碎片被分配到一个设备上。这相当于沿批次(Batch)维度对训练过程进行并行化。每个设备将持有一个完整的模型副本,并在分配的数据集碎片上进行训练。在反向传播之后,模型的梯度将被全部减少,以便在不同设备上的模型参数能够保持同步。典型的数据并行实现:PyTorch DDP。

数据并行分为了两种模式:

Data Parallel(DP)和 Distributed Data Parallel(DDP)。

(1)Data Parallel(DP)

DP是一种单进程多线程的并行策略,只能在单机上进行训练,步骤如下:

1)单进程控制多GPU,即本质上是单进程多线程;

2)首先将模型加载到主 GPU 上,再复制到各个指定从 GPU;

3)将输入数据按照 Batch 维度进行拆分,各个 GPU 独立进行 forward 计算;

4)将结果同步给主 GPU 完成梯度计算和参数更新,将更新后的参数复制到各个 GPU。

5)由于其是单进程控制多个GPU,故会存在GPU之间负载不均衡的问题,主GPU负载较大。

Distributed Data Parallel(DDP)

DDP采用 AllReduce 架构,多进程的方式,突破锁的束缚。在单机和多机上都可以使用。

负载分散在每个 GPU 节点上,通信成本(时间)是恒定的,与 GPU 数量无关,等于V/B(参数量/带宽)。

DDP不需要通过主GPU分发全模型的参数到每个GPU上。

使用ring-all-reduce的方式进行通讯,随着 GPU 数量 N 增加,总传输量恒定。也就是理论上,随着GPU数量的增加,ring all-reduce有线性加速能力。

2、模型并行

通常有两种类型的模型并行:张量并行和流水线并行

- 流水线并行是在各层之间进行并行计算。

- 张量并行是在一个操作中进行并行计算,如:矩阵-矩阵乘法。

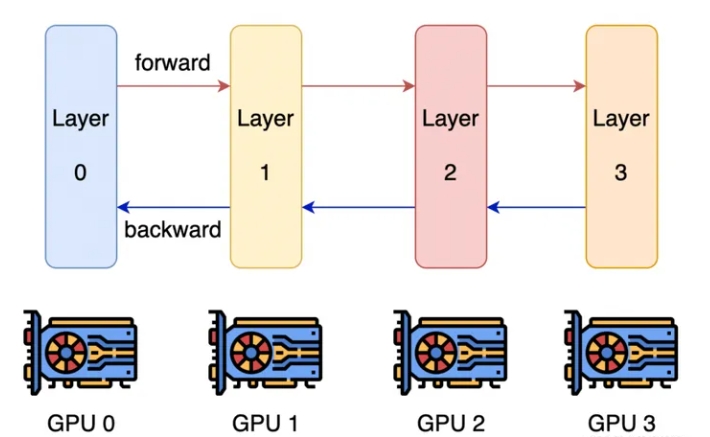

(1)、流水线并行 PP(Pipeline Parallelism)

流水线并行的核心思想是,模型按层分割成若干块,每块都交给一个设备。

在前向传播过程中,每个设备将中间的激活传递给下一个阶段。

在后向传播过程中,每个设备将输入张量的梯度传回给前一个流水线阶段。

这允许设备同时进行计算,从而增加训练的吞吐量。

流水线并行训练的一个明显缺点是训练设备容易出现空闲状态(因为后一个阶段需要等待前一个阶段执行完毕),导致计算资源的浪费,加速效率没有数据并行高。

典型的流水线并行实现:GPipe、PipeDream、PipeDream-2BW、PipeDream Flush(1F1B)

(2)、张量并行TP(Tensor Parallelism)

张量并行:张量并行是另一种并行化技术,它通过将大模型的输入和输出张量拆分,使得多个GPU可以同时处理同一输入张量的不同部分,进一步提高了计算效率。

(3)、优化器并行 ???

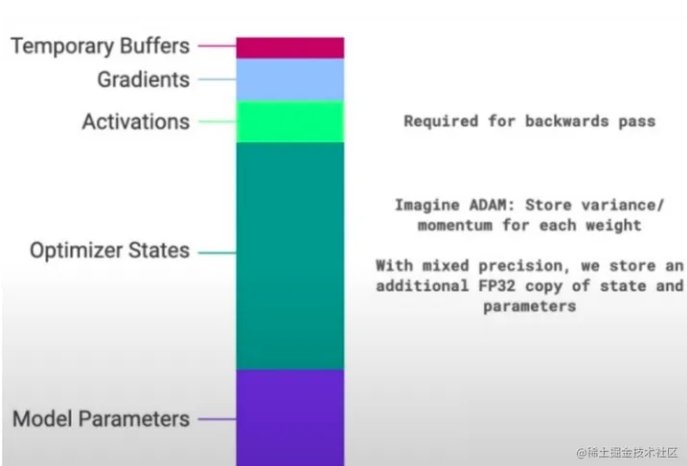

目前随着模型越来越大,单个GPU的显存目前通常无法装下那么大的模型了。那么就要想办法对占显存的地方进行优化。

通常来说,模型训练的过程中,GPU上需要进行存储的参数包括了模型本身的参数、优化器状态、激活函数的输出值、梯度以及一些零时的Buffer。各种数据的占比如下图所示:

可以看到模型参数仅占模型训练过程中所有数据的一部分,当进行混合精度运算时,其中模型状态参数(优化器状态 + 梯度+ 模型参数)占到了一大半以上。因此,我们需要想办法去除模型训练过程中的冗余数据。

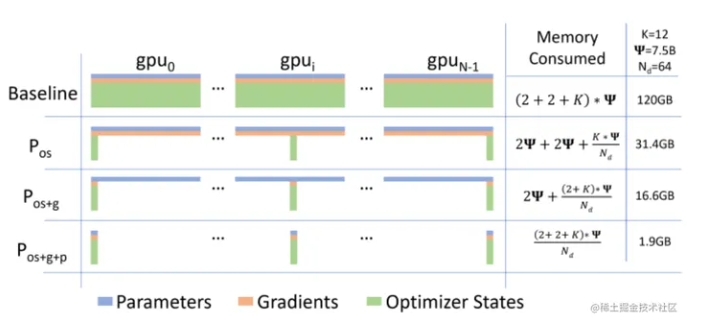

而优化器相关的并行就是一种去除冗余数据的并行方案,目前这种并行最流行的方法是 ZeRO(即零冗余优化器)。针对模型状态的存储优化(去除冗余),ZeRO使用的方法是分片,即每张卡只存 1/N 的模型状态量,这样系统内只维护一份模型状态。ZeRO有三个不同级别,对模型状态进行不同程度的分片:

ZeRO-1 : 对优化器状态分片(Optimizer States Sharding)

ZeRO-2 : 对优化器状态和梯度分片(Optimizer States & Gradients Sharding)

ZeRO-3 : 对优化器状态、梯度分片以及模型权重参数分片(Optimizer States & Gradients & Parameters Sharding)

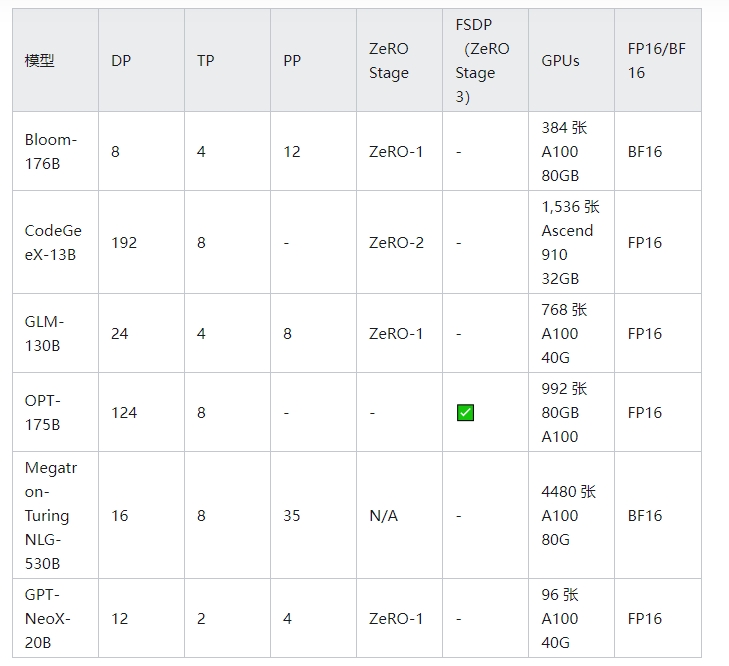

3、3D并行

总的来说,3D并行是由数据并行(DP)、张量并行(TP)和流水线并行(PP)组成

立意高远,以小见大,引发读者对社会/人性的深层共鸣。