信息熵、交叉熵、相对熵、条件熵

信息熵完美编码

交叉熵不完美编码

相对熵是两者的差值,交叉熵减去信息熵。差值即差异,也即KL散度

一、熵:信息熵

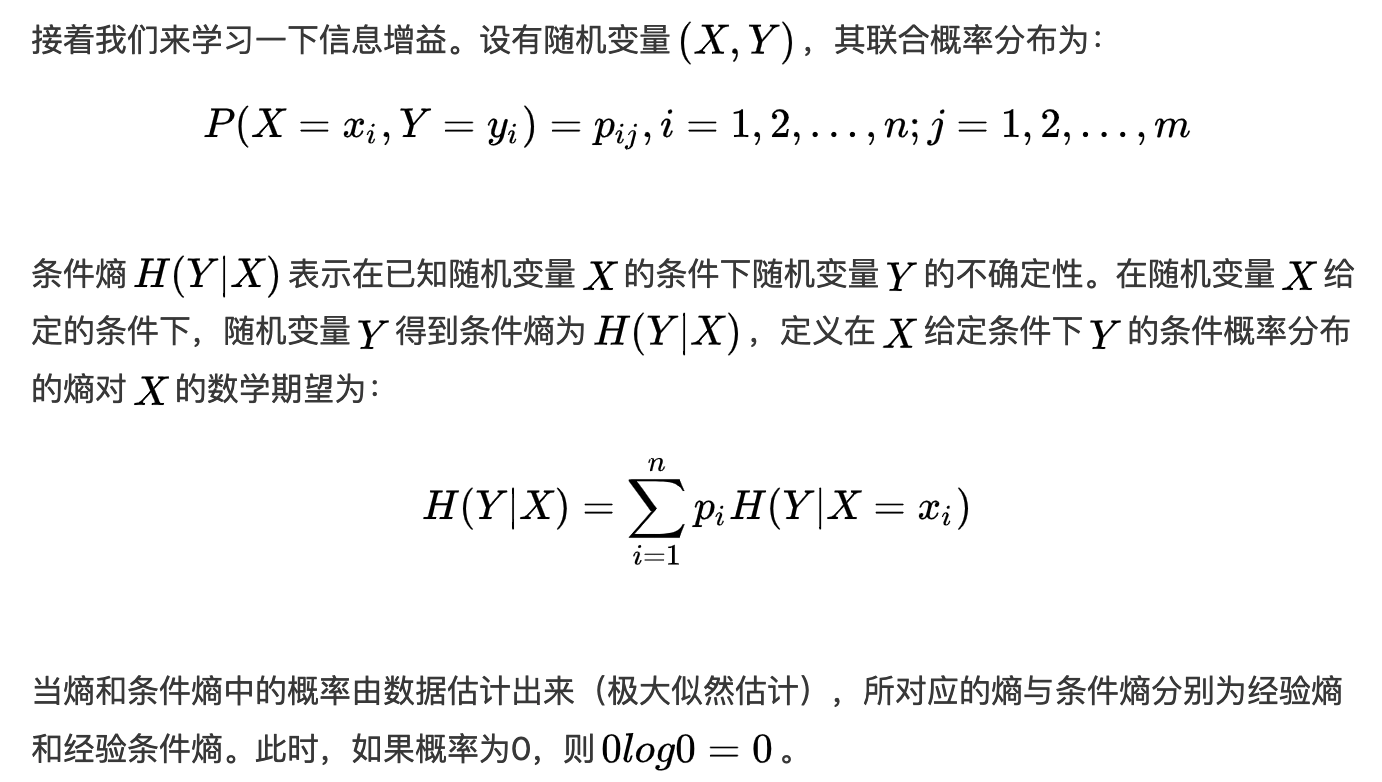

熵(Entropy)是一个热力学概念,在信息论中,熵用来衡量随机变量的不确定性。一个系统越有序,熵越小;越混乱,熵越大。因此熵用来衡量一个系统的有序程度。在机器学习的的过程中,变量的不确定越大,熵越大。设是一个取有限个值的离散随机变量,其概率分布为:

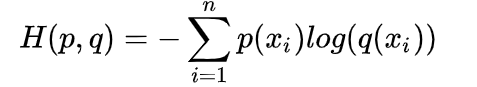

二、交叉熵

1.定义:用来衡量计算出的概率分布和真实概率分布之间的差异

2.公式:

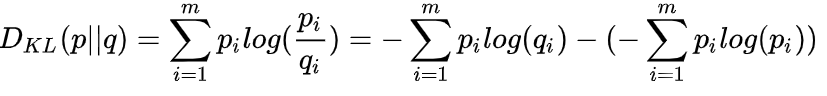

三、相对熵:KL散度

1.定义:用来衡量两个概率分布之间的差异

2.公式:

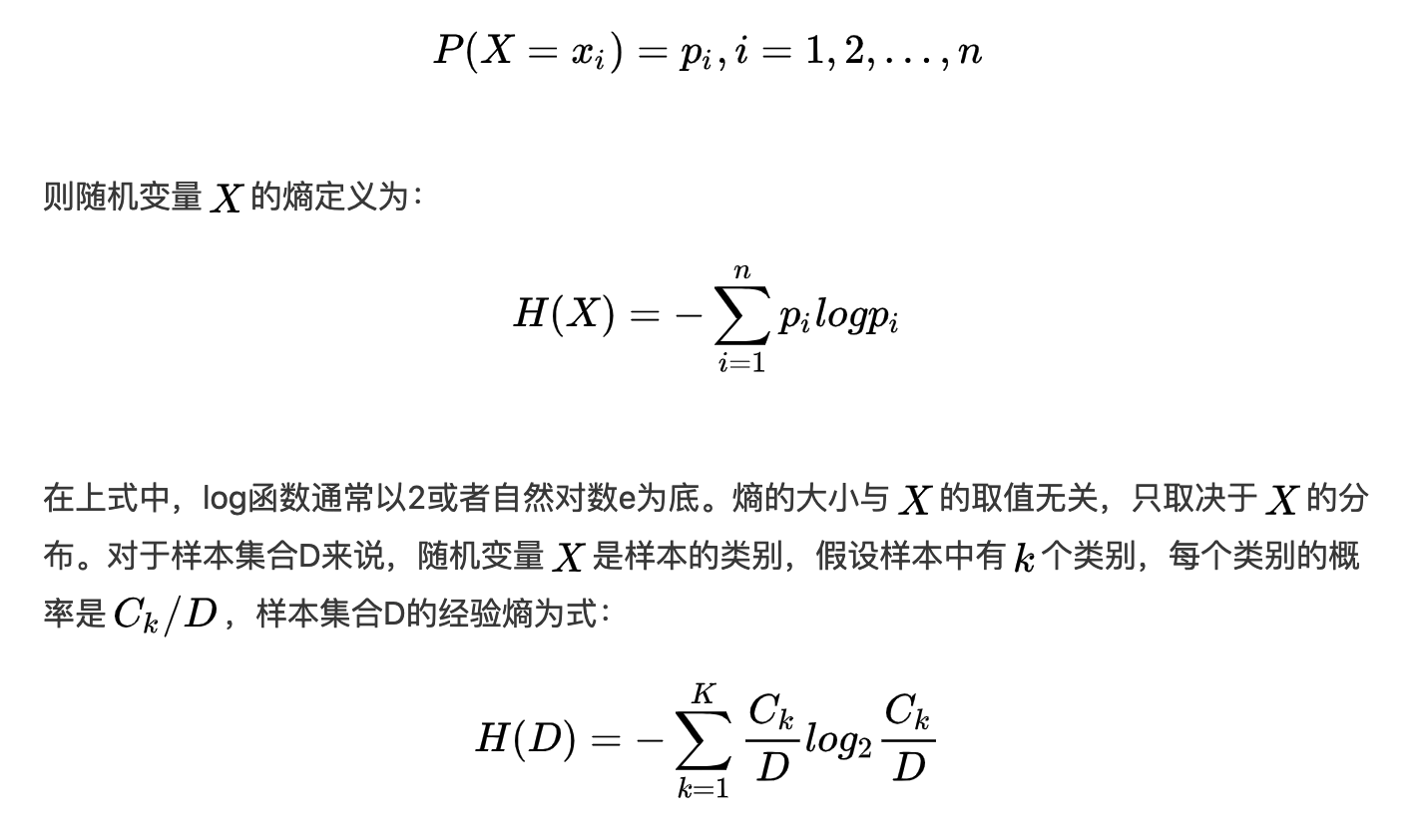

四、条件熵