gbdt算法总结

一、定义

GBDT(Gradient Boosting Decision Tree)(梯度提升决策树)

定义:是为了解决一般损失函数的优化问题,

1.方法是用损失函数的负梯度在当前模型的值来模拟回归问题中残差的近似值。

2.该算法由多棵决策树组成,所有树的结论累加起来做最终结果。

3.在GBDT中,我们每次生成下一个弱学习器,都是把损失函数的梯度作为学习目标(如果损失函数是平分损失,则相当于使用残差作为目标函数),相当于利用梯度下降法进行优化来逼近损失函数的最小值,也就是使得损失函数为0,最终学习器尽可能接近真实结果。

二、梯度提升

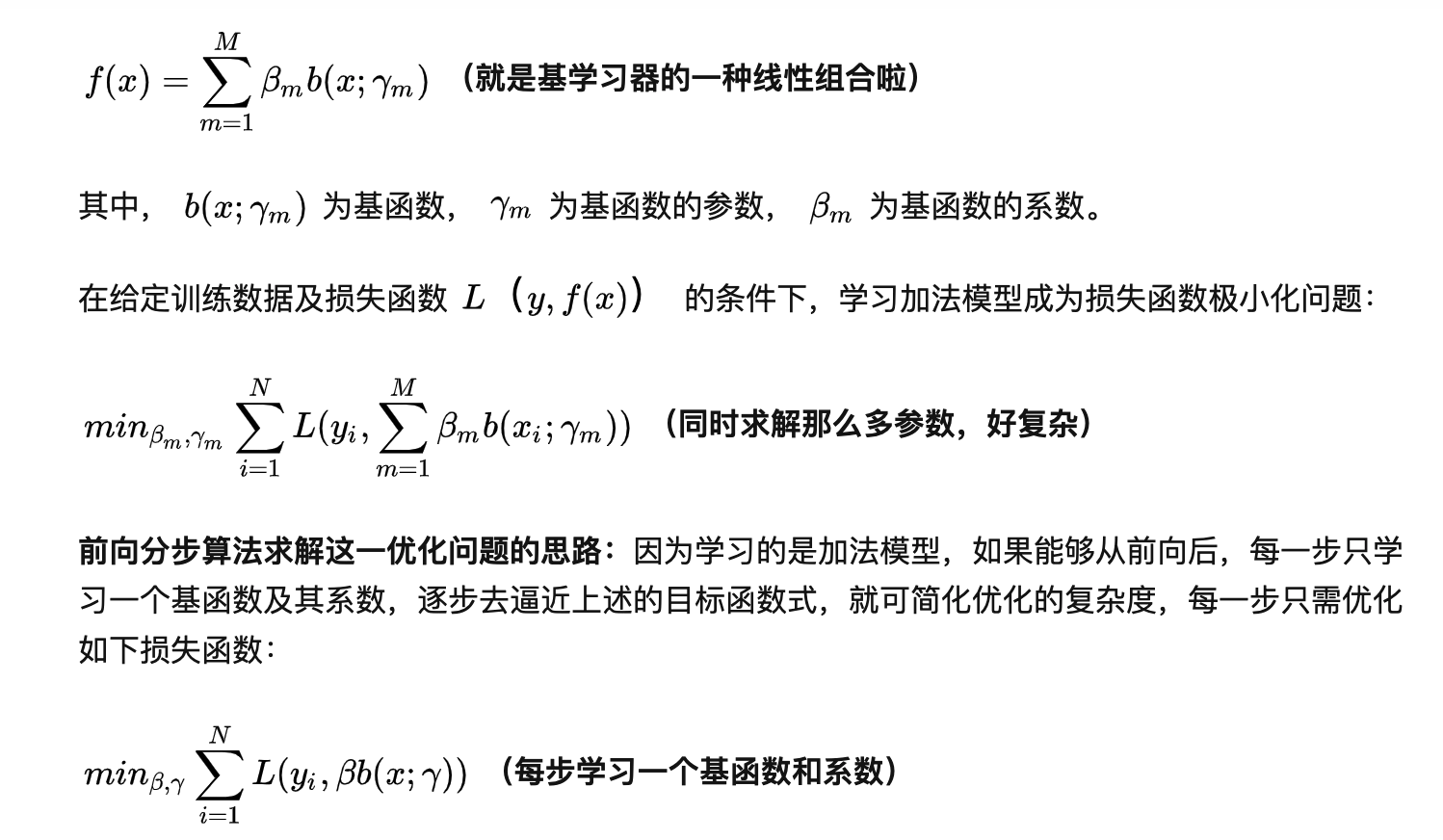

提升树利用加法模型和前向分步算法实现学习的优化过程。当损失函数时平方损失和指数损失函数时,每一步的优化很简单,如平方损失函数学习残差回归树。

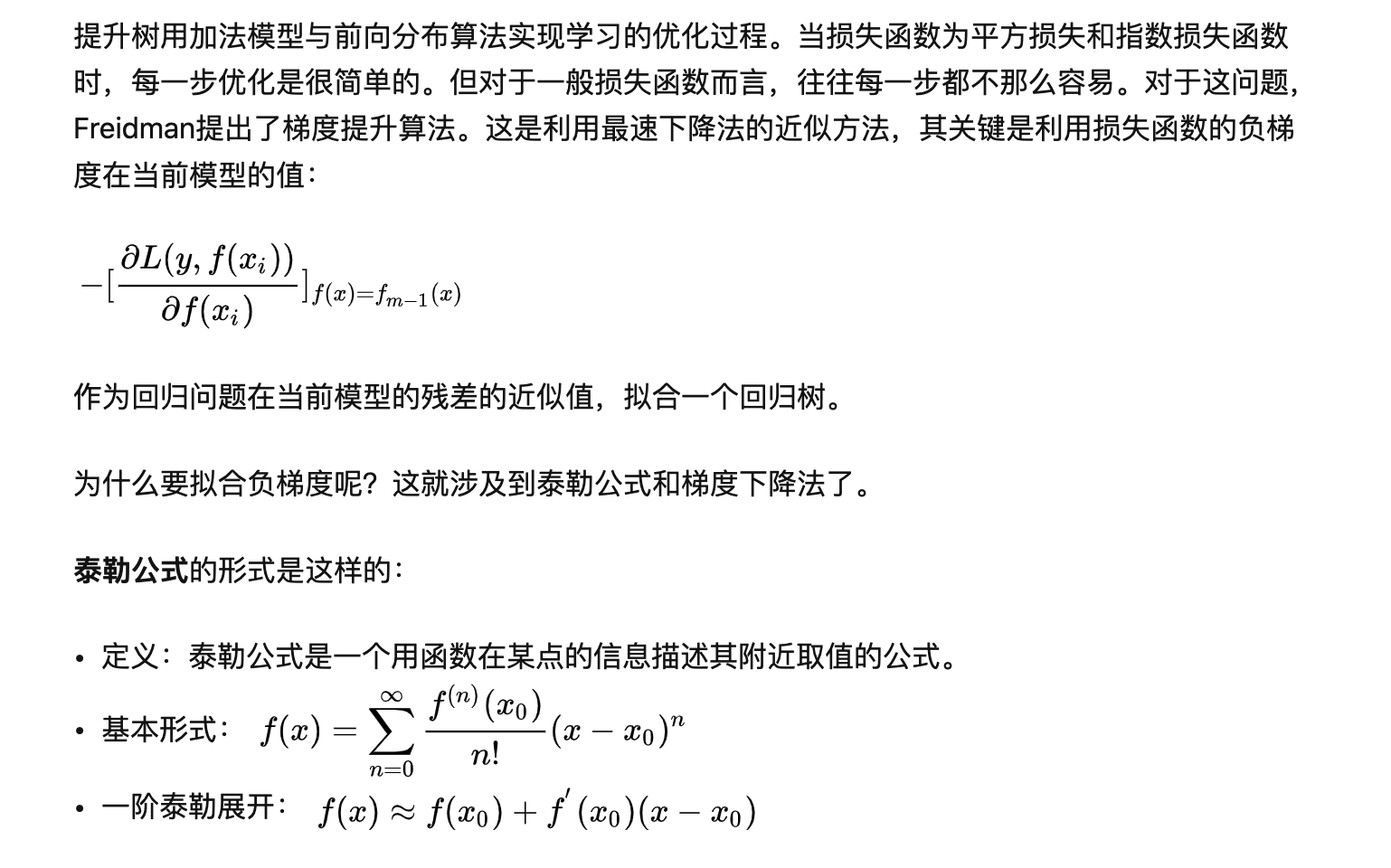

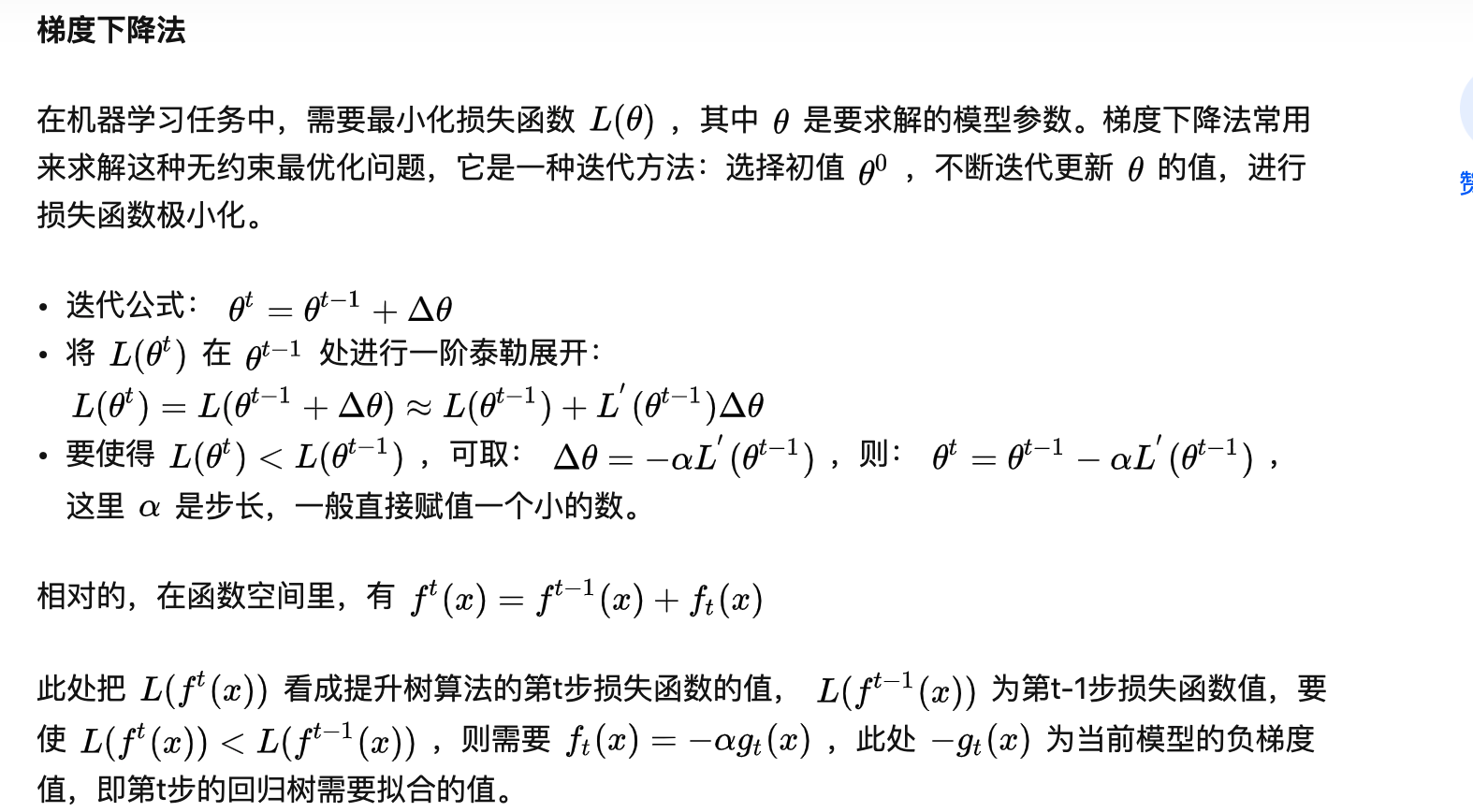

提升树用加法模型与前向分布算法实现学习的优化过程。当损失函数为平方损失和指数损失函数时,每一步优化是很简单的。但对于一般损失函数而言,往往每一步都不那么容易。对于这问题,Freidman提出了梯度提升算法。这是利用最速下降法的近似方法,其关键是利用损失函数的负梯度在当前模型的值:

参数:

gbdt参数详解

class sklearn.ensemble.GradientBoostingClassifier(*, loss='deviance', learning_rate=0.1, n_estimators=100, subsample=1.0,

criterion='friedman_mse', min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_depth=3,

min_impurity_decrease=0.0, min_impurity_split=None, init=None, random_state=None, max_features=None,

verbose=0, max_leaf_nodes=None, warm_start=False, presort='deprecated', validation_fraction=0.1,

n_iter_no_change=None, tol=0.0001, ccp_alpha=0.0)参数:

(1)n_estimators: 也就是弱学习器的最大迭代次数,或者说最大的弱学习器的个数。一般来说n_estimators太小,容易欠拟合,n_estimators太大,又容易过拟合,一般选择一个适中的数值。默认是100。在实际调参的过程中,我们常常将n_estimators和下面介绍的参数learning_rate一起考虑

(2)learning_rate, float,默认= 0.1,学习率缩小了每棵树的贡献learning_rate。在learning_rate和n_estimators之间需要权衡

(3)subsample: 即我们在原理篇的正则化章节讲到的子采样,取值为(0,1]。注意这里的子采样和随机森林不一样,随机森林使用的是放回抽样,而这里是不放回抽样。如果取值为1,则全部样本都使用,等于没有使用子采样。如果取值小于1,则只有一部分样本会去做GBDT的决策树拟合。选择小于1的比例可以减少方差,即防止过拟合,但是会增加样本拟合的偏差,因此取值不能太低。推荐在[0.5, 0.8]之间,默认是1.0,即不使用子采样

(4)loss: 即我们GBDT算法中的损失函数。分类模型和回归模型的损失函数是不一样的。

对于分类模型,有对数似然损失函数"deviance"和指数损失函数"exponential"两者输入选择。默认是对数似然损失函数"deviance"。在原理篇中对这些分类损失函数有详细的介绍。一般来说,推荐使用默认的"deviance"。它对二元分离和多元分类各自都有比较好的优化。而指数损失函数等于把我们带到了Adaboost算法。

对于回归模型,有均方差"ls", 绝对损失"lad", Huber损失"huber"和分位数损失“quantile”。默认是均方差"ls"。一般来说,如果数据的噪音点不多,用默认的均方差"ls"比较好。如果是噪音点较多,则推荐用抗噪音的损失函数"huber"。而如果我们需要对训练集进行分段预测的时候,则采用“quantile”

(5)alpha:这个参数只有GradientBoostingRegressor有,当我们使用Huber损失"huber"和分位数损失“quantile”时,需要指定分位数的值。默认是0.9,如果噪音点较多,可以适当降低这个分位数的值

(6)min_samples_split, int或float,默认为2,拆分内部节点所需的最少样本数:如果为int,则认为min_samples_split是最小值。如果为float,min_samples_split则为分数, 是每个拆分的最小样本数。ceil(min_samples_split * n_samples)

(7)min_samples_leaf, int或float,默认值= 1,在叶节点处所需的最小样本数。仅在任何深度的分裂点在min_samples_leaf左分支和右分支中的每个分支上至少留下训练样本时,才考虑。这可能具有平滑模型的效果,尤其是在回归中。如果为int,则认为min_samples_leaf是最小值。如果为float,min_samples_leaf则为分数, 是每个节点的最小样本数。ceil(min_samples_leaf * n_samples)

(8)min_weight_fraction_leaf, float,默认值= 0.0,在所有叶节点处(所有输入样本)的权重总和中的最小加权分数。如果未提供sample_weight,则样本的权重相等。

(9)max_depth, int,默认= 3,各个回归估计量的最大深度。最大深度限制了树中节点的数量。调整此参数以获得最佳性能;最佳值取决于输入变量的相互作用。也就是那个树有多少层(一般越多越容易过拟合)

(10)min_impurity_decrease, 浮动,默认值= 0.0,如果节点分裂会导致杂质的减少大于或等于该值,则该节点将被分裂

(11)min_impurity_split ,float,默认=无提前停止树木生长的阈值。如果节点的杂质高于阈值,则该节点将分裂,否则为叶

(12)init:计量或“零”,默认=无,一个估计器对象,用于计算初始预测。 init必须提供fit和predict_proba。如果为“零”,则初始原始预测设置为零。默认情况下,使用 DummyEstimator预测类优先级

(13)max_features:节点分裂时参与判断的最大特征数

int:个数

float:占所有特征的百分比

auto:所有特征数的开方

sqrt:所有特征数的开方

log2:所有特征数的log2值

None:等于所有特征数

其他没啥好说的,有兴趣可以自己查看官网https://scikit-learn.org/stable/modules/generated/sklearn.ensemble.GradientBoostingClassifier.html

----------常见问题-------------

1.度提升和梯度下降的区别和联系是什么

下表是梯度提升算法和梯度下降算法的对比情况。可以发现,两者都是在每 一轮迭代中,利用损失函数相对于模型的负梯度方向的信息来对当前模型进行更 新,只不过在梯度下降中,模型是以参数化形式表示,从而模型的更新等价于参 数的更新。而在梯度提升中,模型并不需要进行参数化表示,而是直接定义在函 数空间中,从而大大扩展了可以使用的模型种类。

2.GBDT的优点和局限性有哪些

1 优点

预测阶段的计算速度快,树与树之间可并行化计算。

在分布稠密的数据集上,泛化能力和表达能力都很好,这使得GBDT在Kaggle的众多竞赛中,经常名列榜首。

采用决策树作为弱分类器使得GBDT模型具有较好的解释性和鲁棒性,能够自动发现特征间的高阶关系。

2 局限性

GBDT在高维稀疏的数据集上,表现不如支持向量机或者神经网络。

GBDT在处理文本分类特征问题上,相对其他模型的优势不如它在处理数值特征时明显。

训练过程需要串行训练,只能在决策树内部采用一些局部并行的手段提高训练速度。

3.RF(随机森林)与GBDT之间的区别与联系

相同点:

都是由多棵树组成,最终的结果都是由多棵树一起决定。

RF和GBDT在使用CART树时,可以是分类树或者回归树。

不同点:

组成随机森林的树可以并行生成,而GBDT是串行生成

随机森林的结果是多数表决表决的,而GBDT则是多棵树加权累加之和

随机森林对异常值不敏感,而GBDT对异常值比较敏感

随机森林是减少模型的方差,而GBDT是减少模型的偏差

随机森林不需要进行特征归一化。而GBDT则需要进行特征归一化

随机森林的树可以分类树也可以是回归树,而GBDT只由回归树组成

4.GBDT和AdaBoost区别

Adaboost是通过提高错分样本的权重来定位模型的不足

参考:

1.https://zhuanlan.zhihu.com/p/58105824

2.https://www.jianshu.com/p/005a4e6ac775