2023年5月

此内容被密码保护

chatpdf技术梳理

1.官网

chatpdf没有论文,属于chatgpt的一个应用。

https://www.chatpdf.com/

中文类似网站:

http://www.chatspdf.cn/

2.测试页面

切割错误情况:

3.技术原理

1.pdf转文本

读取PDF文件,将其转换为txt格式的文本文件。

2.数据预处理

对文件进行清理和标准化,例如去除特殊字符,保留标题和文本,按照自然段落进行分割。

3.段落embedding

ChatPDF使用OpenAI的Embeddings API将每个分段转换为向量,这个向量将对文本中的语义进行编码,以便于与问题的向量进行比较

4.用户query问题embedding

当用户提出问题时,ChatPDF使用OpenAI的Embeddings API将问题转换为一个向量,并与每个分段的向量进行比较,以找到最相似的分段。这个相似度计算可以使用余弦相似度等常见的方法进行。

5.prompt工程

ChatPDF将找到的最相似的分段与问题作为prompt,调用OpenAI的Completion API,让ChatGPT学习分段内容后,再回答对应的问题。

难点思考:

1.切断粒度的划分:以什么为维度切片,chatpdf也有切错情况,如上图。

2.提示语句的实验

3.chatpdf存在的问题:

(1)概括性的问题无法找到答案

(2)对于语义非常相似的文本能找到对应位置,但是上下文语义可能存在切错误情况。

4.推荐先通过chatgpt快速实验一版方案,然后替换大模型自研

4.复现代码参考

https://www.alanwang.site/blog/chatgpt-pdf

https://blog.csdn.net/m0_55868614/article/details/129639067

大模型和知识图谱融合

大模型预训练参数、数据、训练时间

nohup python pre_brand.py>>./train.log 2>&1 &

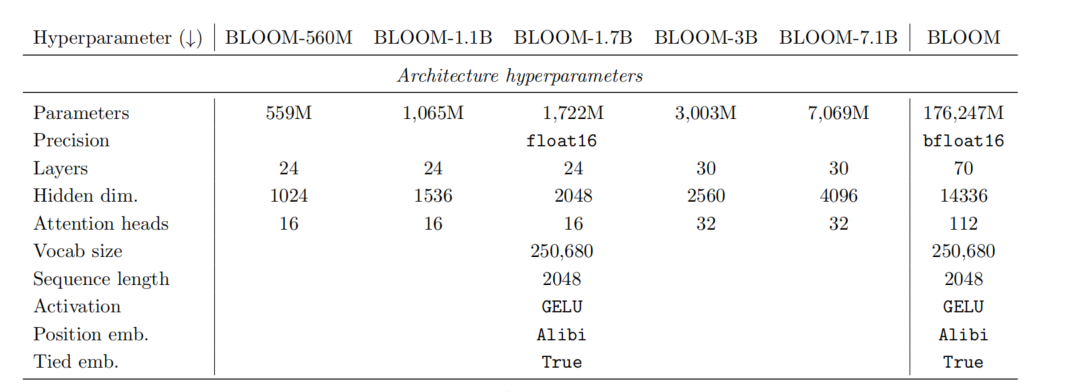

一、Bloom

1.参考论文

https://arxiv.org/pdf/2211.05100.pdf

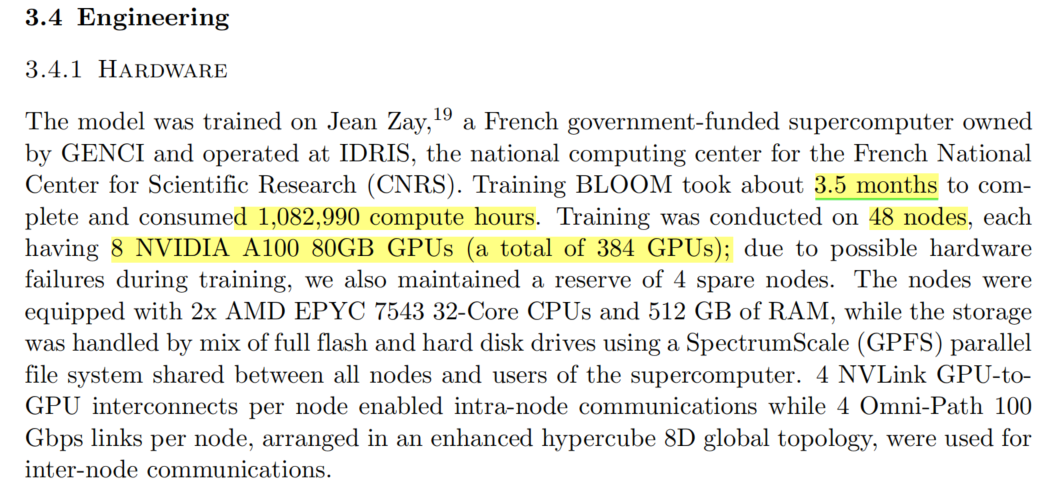

2.硬件组成

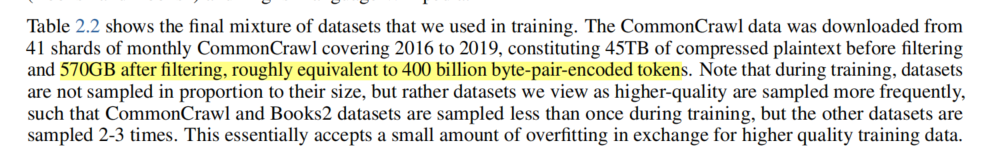

3.数据量

epoch:

token:3500亿token

4.网络参数

模型参数量:176B

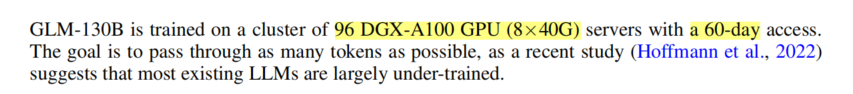

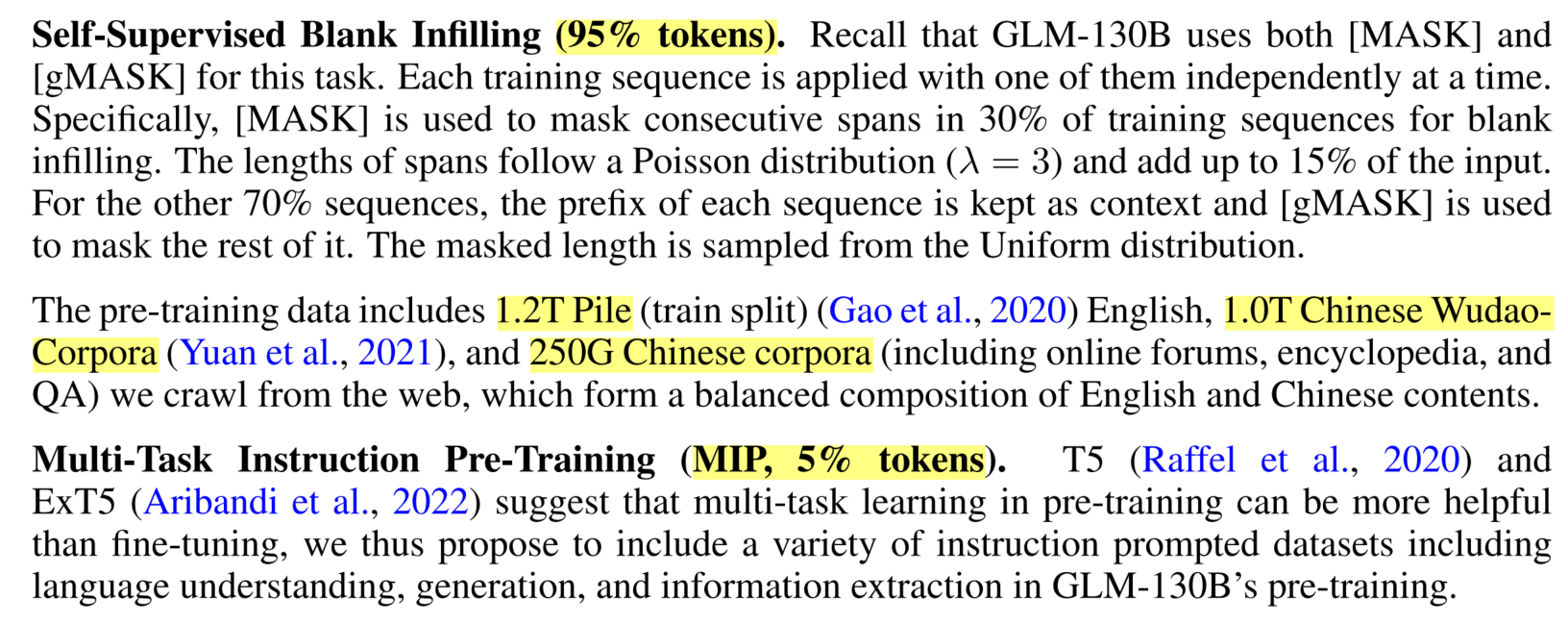

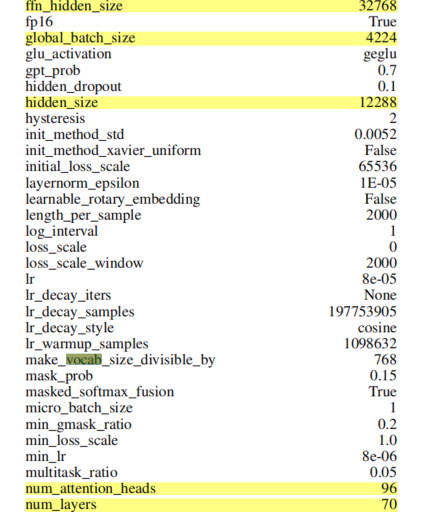

二、GLM

1.参考论文

https://openreview.net/pdf?id=-Aw0rrrPUF

2.硬件组成

3.数据量

epoch:1

token:4000亿token

4.网络参数

模型参数量:130B

三、GPT-3

1.参考论文

https://arxiv.org/pdf/2005.14165.pdf

2.硬件组成

论文中没有说明:

。英伟达表示,GPT-3 需要 512 颗 V100 显卡

训练 7 个月,或者 1024 颗 A100 芯片训练一个月

3.数据量

epoch:1

token:4000亿token

4.网络参数

模型参数量:175B

四、LLaMa

1.参考论文

https://arxiv.org/pdf/2302.13971.pdf

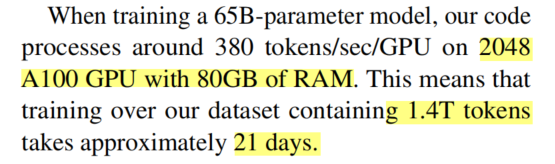

2.硬件组成

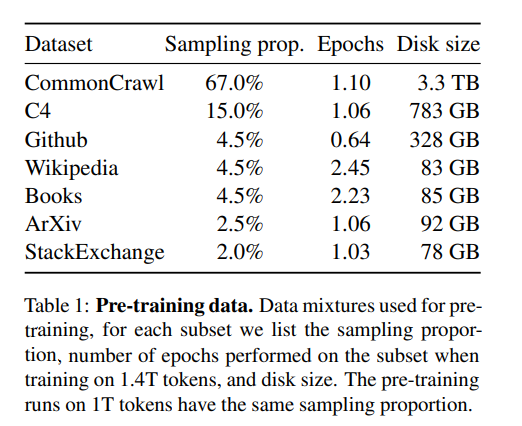

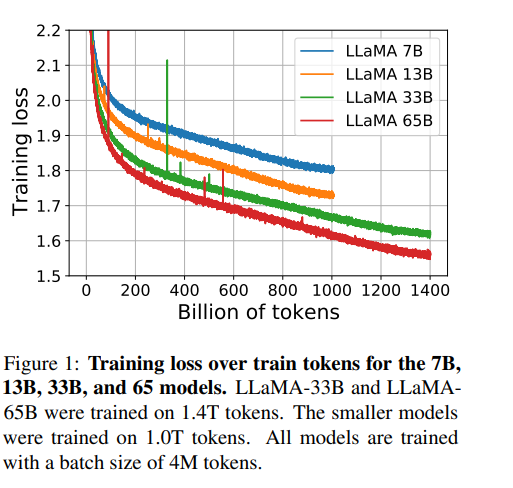

3.数据量

epoch:1

token:1.4万亿

disk size:4.9TB

4.网络参数

模型参数量:

参数大小:65B

| 模型 | 参数量 | 训练数据disk size | 训练数据tokens | 训练时间 | GPU数量 | epoch | 2B参数,500G语料预估训练天数 |

|---|---|---|---|---|---|---|---|

| Bloom | 176B | 1.6TB | 3500亿 | 205天 | 384 A100 80G=30TB显存 | 1 | 35天 |

| GLM | 130B | 2.4TB | 4000亿 | 60天 | 768 A100 40G=30TB显存 | 1 | 12天 |

| GPT3 | 175B | 570GB | 4000亿 | 30天 | 1024 A100 80G=80TB显存 | 1 | 12天 |

| LLaMa | 65B | 4.9T | 14000亿 | 21天 | 2048 A100 80G=160TB显存 | 1 | 13天 |

| 我们 | 2B | 0.5T | 1100亿 | ?天 | 8 A100 80G=0.625TB显存 | 1 | 12-35天 |